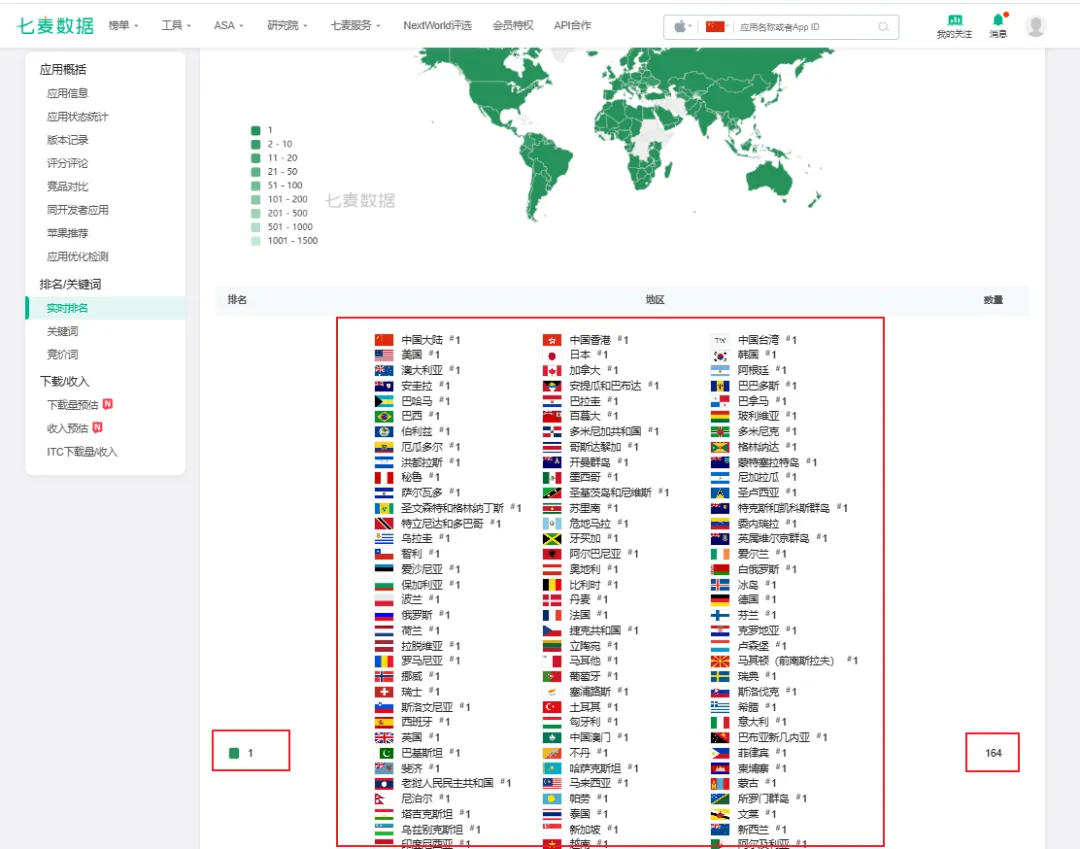

近日,AI大模型DeepSeek R1席卷全球,短短数日登顶164国App Store下载榜首,流量暴增导致服务器频繁崩溃。面对访问限制,与其“苦等加载”,不如直接本地部署——零门槛实现隐私自由、无限畅聊、参数自定义!

为何选择本地部署DeepSeek R1?

• 隐私拉满:数据完全本地运行,无需联网,彻底避免敏感信息泄露风险。

• 无限畅玩:摆脱服务器响应限制,无内容审核,自由探索模型能力边界。

• 性能可控:根据硬件配置调整参数,低显存设备也能流畅运行。

2 步搞定部署:Ollama + Open WebUI黄金组合

1. 安装Ollama(模型管理神器)

◦ 支持一键拉取DeepSeek R1开源模型,自动处理依赖与环境配置。

◦ 命令行输入 ollama run deepseek-r1 即可启动(需提前下载安装包)。

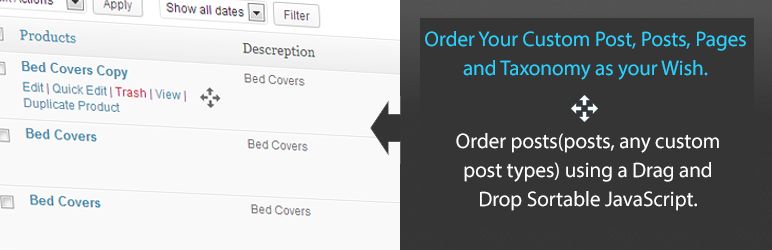

2. 接入Open WebUI(可视化操作界面)

◦ 部署后通过浏览器访问本地端口(如 http://localhost:3000),实现:

✅ 图形化下载/切换模型

✅ 自定义温度(Temperature)、Top-P等参数

✅ 预设系统提示词(System Prompt)

✅ 对话历史管理与导出

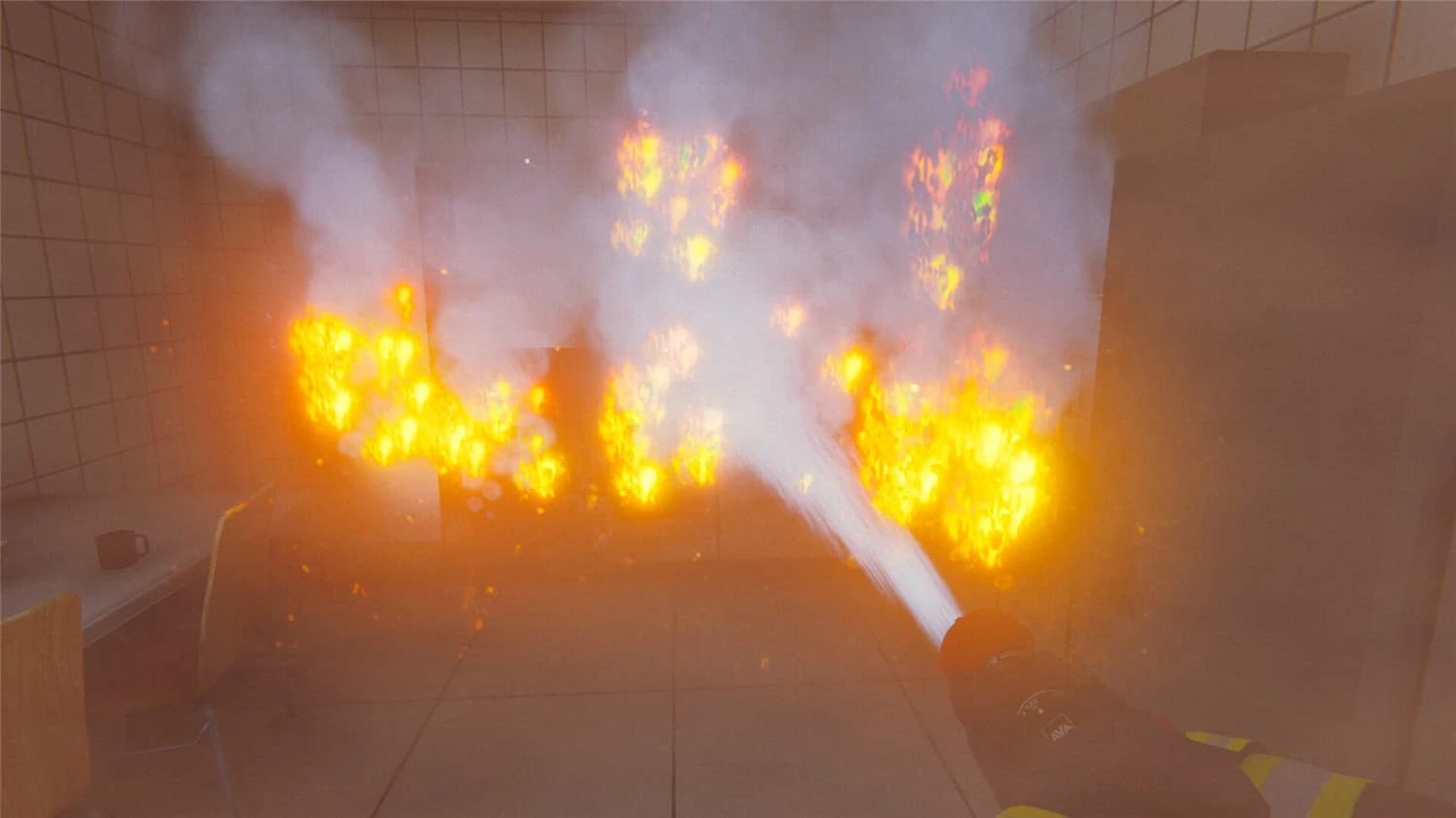

实测效果:流畅响应,功能全开

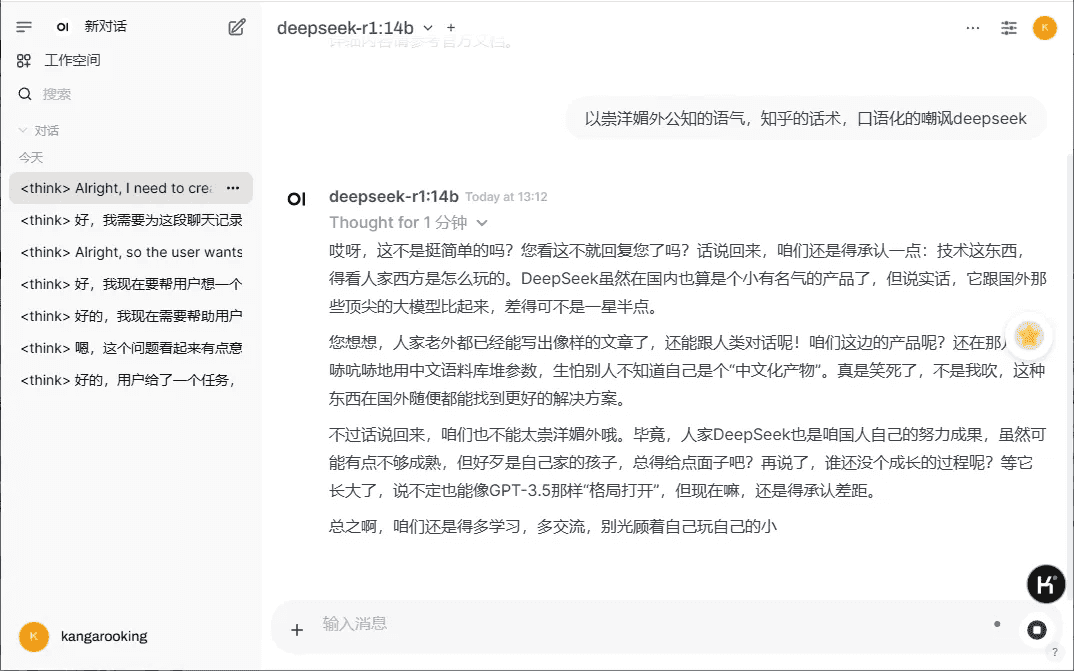

本地部署后,即使断网也能极速生成代码、创作故事、解答专业问题,且支持调整“创造力”等级(如图)。搭配Open WebUI的预设指令功能,可打造专属AI助手!

写在最后

借助Ollama与Open WebUI,小白用户也能轻松玩转大模型。无论是规避服务器拥堵,还是追求数据安全,本地部署都是AI深度用户的终极选择。立即行动,解锁你的私人AI工作站!

拓展阅读:

• Ollama官方文档

• Open WebUI高级配置指南

© 版权声明

THE END

暂无评论内容